概要

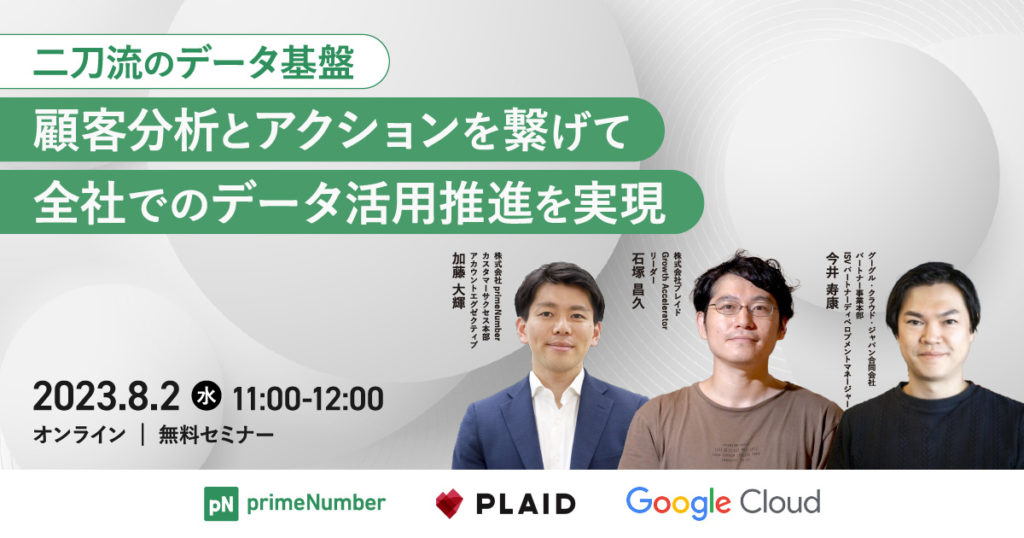

本セミナーでは、KARTE・Lookerを活用して顧客分析施策の実現および企業内でのデータ分析環境の浸透を最大化する方法に焦点を当てます。データ分析基盤は構築して終わりではなく、「活用」されることで迅速に適切な意思決定を行えます。

今回は、データの可視化・社内への活用推進を行うツールとして「Looker」、顧客分析施策を実現する「KARTE」、データを集約するツールとして「TROCCO®」をご紹介します。また、それらのツールを組み合わせて構築するデータ分析基盤を構築するメリットについても触れます。

無料のセミナーですので、ぜひお気軽にお申し込みください。

こんな方におすすめ

- データ分析を行いたいが、データの収集や前処理に苦労している方

- スモールにデータ分析、基盤構築を行いたい方

- 顧客分析施策とアクションのアイディアを欲している方

このセミナーでわかること

- KARTEとTROCCO®とLookerの基本的な機能

- Lookerを使用したデータの可視化・管理方法

- 顧客分析施策向けのデータ分析基盤の設計

なお、当日のセミナーはこちらからご覧いただけます。

※本イベントレポートの内容は当時のものです。TROCCO®の利用や接続オプションなどの利用の詳細について知りたい方はprimeNumberまでお問い合わせください。

https://trocco.io/inquiry/new

講演者紹介

今井 寿康氏

グーグル・クラウド・ジャパン合同会社 ISV パートナーデベロップメントマネージャー

2005年に大学卒業後、AV家電メーカーで10年以上 EC/直営店舗/CRM/MA・カスタマージャーニー戦略などのD2C領域のマーケティングを経験。経営企画として社内数千人規模でのBI活用を推進した後、Lookerに出会い2019年にジョイン、パートナー様との企業変革に従事し、現在は Google Cloud に所属。

石塚 昌久氏

株式会社プレイド Growth Accelerator リーダー

2012年に日本IBMに入社し、データ分析を用いたコンサルティング業務に従事。2018年11月よりプレイドに参画し、社内のデータ分析とBIツールの整備を推進。2022年よりビジネスサイドの各チームの業務推進・改善活動を加速するための組織(=Growth Accelerator)を立ち上げ。現在はGrowth Acceleratorのリーダーとして社内オペレーションとデータの整備・可視化を推進中。

加藤 大輝

株式会社primeNumber カスタマーサクセス本部 アカウントエグゼクティブ

製造業(マルハニチロ株式会社、ネスレ日本株式会社)にて、小売業向けの製品開発・営業・データ分析活動に従事。現在は、広告・IT関連から製造・小売りまで業界を問わず、データ活用基盤の構築を支援。

SECTION 1 :顧客分析とアクションを繋げて全社でのデータ活用推進を実現

SECTION1では今井氏より、「顧客分析とアクションを繋げて全社でのデータ活用推進を実現」について解説していただきます。

今井氏:「本日のセミナーでは二刀流データ基盤について詳しく解説します。具体的には、顧客分析とアクションをどのように繋げてデータ活用を全社的に推進するかについて説明します。」

Google Cloudのミッション

今井氏:「Google Cloudの使命は、あらゆる組織がデジタル変革に取り組む速度を加速させることです。私たちGoogle Cloudが目指すのは、企業のデジタル変革、一般的にはDX(デジタルトランスフォーメーション)の支援を行うことです。」

データ活用のフロー

今井氏:「私たちが提供するソリューション群は、データの分析や活用、ビジネスインテリジェンス(BI)から施策実行、機械学習(ML)、製品やサービスの開発と、業務ワークフローにおける幅広い課題解決を目的としています。

今日は、企業全体でのデータ活用を推進する5つの主要なプロセスについて取り上げます。この中で重要なのが、データをビジネスへと活用することです。具体的にはマーケティング施策を行ったり、どのような顧客に対して何を提供すべきかを判断するなどのデータ分析を行います。

これらの分析は一般的に、BIツールなどを使ってデータを可視化し、解釈します。今日ご紹介するLookerは、これらの業務をサポートする商品です。しかし、それらを実現する前に、データの集約や蓄積といった基盤の構築が求められます。その部分が最も重要な課題となると考えています。」

全社でのデータ活用推進を遅らせる3つの分断

今井氏:「全社でのデータ活用を推進する上での三つの障害要素についてお話ししたいと思います。

一つ目は、データが分断されてしまっているケースです。これは全員がデータを共有できず、その結果データ活用が不十分になってしまいます。

二つ目は、データの定義がバラバラだという問題です。同じデータでも、その定義が異なってしまうと一緒に使うことが困難になるため、全社的なデータ活用が妨げられます。

三つ目は、業務フローが分断されてしまうことで、データを全社でクイックに利用することが困難となる問題です。

これらの問題は、まるでバケツリレーのようにデータ活用の妨げとなります。しかし、これらの問題を一つずつ解決すれば、全社的なデータの活用が促進されます。」

各部門で顧客データが分断されていないか

今井氏:「同じ顧客に接しているのに、部門ごとで顧客データが分断されているという問題が見受けられます。

具体的には、マーケティング、営業、カスタマーサクセスといった部門で、それぞれの部門がその顧客に対して価値を最大限に提供するために活動しています。しかし、それぞれの部門が異なるSaaSを使用していたり、データベースの運用方法が異なるために、同じ顧客であるにも関わらず、それぞれの部門で顧客のデータが分断され、まるで3つの異なる顧客が存在しているかのように見える状況になります。

このことが、全体としての顧客理解やデータ活用の阻害要因になっています。」

データの分断 「データのサイロ化」が全社データ活用を阻害する

今井氏:「データの分断、いわゆる「データのサイロ化」が全社でのデータ活用を妨げる一因となっています。部門ごとに異なる情報系システムを利用しており、利用者や部門によってそれぞれロジックやデータ定義が異なるため、一貫したデータ利用やガバナンスの確立が難しい状況です。

これに加え、多様化するデータソースとそれを取り扱うパイプラインの複雑化が、さらなる課題となっています。

営業、マーケティング、財務など、各部門がそれぞれの業務に応じた情報系システムを保有していることから、同じ企業内でもデータが異なるデータベースに存在し、その集計方法や定義が異なるケースが見受けられます。

この問題を解決するための一つの提案として、全社的な視点でデータを管理し、蓄積する体制の確立を考えています。」

統合データベースの活用によるデータサイロの解消

今井氏:「データ分析とデータ活用を同時に進めるというのは、データウェアハウスを全社で運用するという考え方になります。

ビジネスインテリジェンスにおける施策の実行は、抽出・変換・格納(ETL)とビジネスインテリジェンス(BI)の2つの競うウータフローに基づくことから始まります。これはデータの抽出、変換、格納からデータの蓄積、データモデルの作成、機械学習の活用に至るまでの一連のプロセスを含むものです。

これにより、製品やサービスの開発に関わる情報をスムーズに取り扱えるようになり、オンプレミス、クラウド、ローカルファイルといった形で保存されたデータへのアクセスも容易になります。

その結果、データウェアハウスの有効活用が促進され、データの活用度が向上します。」

データサイロを解消する Smart Analytics ソリューションの中心 BigQuery

今井氏:「問題解決の「Smart Analyticsソリューション」の中心に位置するのが「BigQuery」です。BigQueryは、テラバイト(TB)規模から数百ペタバイト(PB)規模の巨大なデータを取り扱うことが可能なデータウェアハウスです。しかも、その利用は従量課金型であり、最初の”$300″は無償でトライアルできます。

BigQueryは、個々のクエリごとに”10,000″行、プロジェクト全体で”100,000″行のデータを処理できます。

私たちGoogle Cloudからの提案は、「BigQuery」を利用していただき、運用コストを気にせず、サーバー運用についてはすべてGoogle Cloudに任せてしまうということです。これにより、お客様は非常に高速に、並列で、大量のデータを扱えるデータウェアハウス「BigQuery」を気軽に利用できるようになります。

データ活用を始めていくに当たっては、小さく始めてみるという試みも重要です。そのため、「重量課金」という料金形態を取っています。つまり、お客様ご自身が試してみようと思ったときに、最初の”300ドル”までは無償で利用いただけます。

個人的なGmailアカウントをお持ちであれば、”BigQuery”で検索してすぐに使っていただくことが可能です。クラウドのデータウェアハウスのスピードや価値を直接体感していただけます。

このようなデータを統合して収容する「箱」が必要とされる時代になっていると、私たちは感じています。」

データ統合による、お客様共通理解への第一歩

今井氏:「データの統合はお客様について共通理解を得る第一歩ですが、それはまだ始まりに過ぎません。

たとえば、以前は3人の視点で見ていたお客様が、データの統合によりやっと1人の視点で見えるようになった、といった状況を想像してみてください。

しかし、本当に重要なのは、この統合されたデータをどのように活用するか、つまりデータの見える化と分析です。マーケティング、営業、カスタマーサクセスの各部署が統合されたデータベースを使うことにより、全体像を把握しやすくなります。」

データ定義の分断

今井氏:「しかし、それだけではまだデータ活用が完全には実現できない可能性があります。これは、“データ定義の分断”という問題が関わっています。

具体的には、各種ツールを使い、ダッシュボードやBIで可視化し、顧客の状況を把握し理解を深めることが重要です。

しかしこの過程で、異なる部門や人ごとにダッシュボードを作ると、集計指標の定義が異なる場合があるため、データが正しく活用できない可能性があるのです。また、SQLを使ってデータを取得するケースでも、SQLでの集計ロジックが人によって異なるため、データの定義が一致しないという問題が頻繁に起きます。」

今井氏:「単にデータを集約するだけでは充分ではありません。データの定義に関して大きな問題が生じることがあります。

例えば、営業部の見ている売上達成率と、それとは違う見方をしている他部署との間で、数字の解釈や計算方法に違いがあったりします。

またマーケティング部のCVR(コンバージョンレート)が営業部から見るとあまり良いとは感じられなかったり、LTV(ライフタイムバリュー)のような指標の定義が頻繁に変わると、それにともなってダッシュボードを全て作り直さなければならない状況が発生します。

それぞれの部署が自己流のダッシュボードを作成、可視化している結果、データが統合されない上に、データの定義が部署ごとにバラバラになってしまいます。その結果、全社として同じ意味でデータを理解し活用することが困難になります。

これが、データの分断という状況です。」

データガバナンスが欠落した状態

今井氏:「スライドでは、これを「データガバナンスが欠落」と表現しています。つまり、データの定義がルール化されておらず、統一的な理解がなされていない状態です。」

Google Cloud のデータ分析&ソリューション:Looker

今井氏:「私たちが推奨しているGoogle Cloud のデータ分析ツールには、BigQueryという統合データベースがあります。BigQueryは、様々なBIツールからも自由に使用できます。

しかし、最も私たちが強く提案したいツールはLookerです。Lookerを使えば、スプレッドシートから直接、大量のデータを探索することも可能になります。」

Lookerとは

今井氏:「Lookerはデータ活用のためのプラットフォームであり、データガバナンスを管理します。ビジネスユーザーは、必要なタイミング、場所でデータの取得が可能です。これにより、データの可視化に留まらず、各種ツールへの連携も行い、データを次のアクションに繋げていくことができます。

このシステムではデータのアップロードが不要で、データ定義が統一されています。また、ワークフローへも組み込むことができます。

私たちの会社では、これを単なるBI(ビジネスインテリジェンス)ツール以上のものと捉えており、データガバナンスを統括するデータ活用プラットフォームとしてご紹介しています。」

Lookerの全体像

今井氏:「Lookerは、詳しい各種データを一元管理し、並行して管理を行います。主に、データウェアハウスやデータベースなどのBigQueryに接続でき、それらのデータベースに個別にSQLを集計する必要がなくなります。

Lookerは、各データベースに対応したSQLを自動で発行し、取得したデータを可視化したりします。その可視化の画面をポータルサイトなどに埋め込むことが可能です

また、Lookerの画面を見るのではなく、必要な情報を特定のスケジュールで自動配信して受け取ることも可能です。

さらに、API機能を使用してデータだけを取り出し、他のプロセスで自動的に利用する用途にも対応しています。

この一元管理と自動化がなぜ有益かというと、ビジュアライズや各種ツールの画面を見ることなく、直接データにアクセスして必要な情報を取得し、それを活用することが容易になるからです。」

Lookerの3つの特徴

今井氏:「Lookerには、3つの主要な特長があります。

第一に、データをアップロードする必要がないことです。従来、BIツールの導入の際にはBIツール用のデータベースを別途準備する必要がありましたが、Lookerなら既存もしくは新たに作成したデータウェアハウスに直接アクセス可能です。

そのため、高速なデータウェアハウスの性能をそのまま活かすことができ、データを2重に管理する必要がないというメリットがあります。

第二に、Lookerはデータの定義を統一する機能を持っています。これはLookML(Looker Modeling Language)という自社開発の言語で実現しており、SQLを自動生成することが可能になります。

データの一元管理が可能となり、誰でも同じ定義でデータを利用することができます。データの定義が分断されることを解消し、SQLを書く手間も削減できます。

さらにLookerでは、全てのデータ管理をGitで行えるため、バージョン管理も容易です。

加えて、既存のワークフローにデータを簡単に受け渡すことも可能です。この詳細は後ほど解説いたします。」

データ利活用の推進・データドリブン文化実現によくある課題

今井氏:「データ活用の推進やデータドリブン文化の実現には、二つの課題がよくあると言えます。

一つ目は、データボトルネックと呼ばれる問題です。データ抽出にSQLを用いる場合、作業者が限られるため、分析や活用が待たされるという問題があります。また、ユーザーにデータをタイムリーに提供できないことや、SQLの共通管理が難しく、業務が個人依存になってしまうことも課題です。

二つ目は、データカオスという問題です。個々の人々が自由にデータ集計やレポーティングすることで混乱が生じる可能性があります。具体的には、指標の定義が混ざり合い、正しい意思決定を妨げることや、定義を変更する際にレポート単位で集計変更を行う必要があることが問題となります。

弊社のLookerがこれらの課題を解決できると考えています。」

ガバナンスを持ったデータ プラットフォームが重要

今井氏:「ビジネスユーザーが幅広く高い鮮度でデータにアクセスできるようにするため、データの共通利用を推進する考え方が大切です。そのために、データガバナンスを徹底し、共通の言語としてデータを利用する環境を整備します。単純な分析ツールを使用するのではなく、データプラットフォームの構築が重要となります。

Lookerを使い、データガバナンスのあり方を再定義し、SQLの作成やデータの共有に関する取り組みを進める必要があります。これにより、全て共通の指標定義による一貫した結果を出し、より確実な意思決定が可能となります。

レポーティング以外の業務にも、データをシームレスに連携できる環境の整備が重要です。統合データベースに集約されたデータをビジネスユーザーがすぐに使えるようにするためには、SQLの作成を減らすとともに、SQLと実際のデータ取得をつなげる部分でデータを定義するデータガバナンスレイヤーの適用が重要です。

データガバナンスレイヤーにより、一貫したガバナンスの下で指標の定義が可能となり、ビジネスユーザーがリアルタイムでデータを使用し、可視化したり業務に活かすことができます。

どの部門がデータを取得しても同じ定義のデータになり、異なる部門でも安心して使用できます。この方法によって、データの共通利用とデータの共通言語化を実現できます。

BIツールを導入する際に注意が必要なのは、可視化だけでなく、このようなデータプラットフォームの構築が重要であるかという点です。」

データ活用のフローと、実現のためのソリューション群

今井氏:「データ活用のフローと、その実現のためのソリューション群を説明します。

業務フローには、データウェアハウスによるストレージ・集約、データモデルによる分析、さらに機械学習(ML)を活用して製品やサービスを開発する流れが含まれます。

しかし、業務フローが分断され、データが分散している状況では、大量のデータを効果的に活用できません。データ統合から活用体制が整っているとしても、業務フローが分断されている場合、最適なデータ活用が難しくなります。

データ活用における業務フローは、大量のデータが分散されている状態から始まります。まずこのデータを抽出し、データの収集と変換・格納、いわゆるETL(Extraction, Transformation, Loading)を行います。これはデータ活用の実現のためのソリューション群の一環であり、データ基盤の事前準備に該当します。

次にデータ分析を行い、その結果を基に具体的なデータ活用策を考えます。これは施策の実行や業務ワークフローに直結し、例えば機械学習(ML)による製品・サービス開発や、ビジネス担当が各種マーケティングツールで操作するなどの行動に繋がります。

しかし、実際にはIT担当とビジネス担当間で業務が分断されてしまうケースが意外と多いです。データ基盤の準備はIT担当が主導する一方で、データ分析はビジネス担当が直接見たり、IT担当が行ったりと役割が曖昧です。

さらに、得られたデータをマーケティングツールで再度操作し直さなければならないといった問題も生じています。

こういった手続きが業務を分断し、結果的に全社でのデータ活用を遅らせてしまう可能性があります。では、この課題をどう解決すべきか、というのが私たちが向き合うべき課題です。」

一気通貫なデータ活用を実現する

今井氏:「ビジネス担当者でも使いやすいソリューションを組み合わせて、一気通貫でのデータ活用ができる環境をつくります。これには、マーケティング施策の計画から実行までのフローを全て網羅する必要があります。

そのために私たちは、Webやアプリのデータをリアルタイムで解析し、わかりやすいインターフェースを持つTROCCO®というツールでデータをBigQueryに入力します。そして、そのデータをLookerで見ることで、より詳細な顧客分析とマーケティング計画の立案が可能となります。

さらに、Lookerからマーケティングソリューションにデータを送ることにより、一元的な施策実行も可能となります。具体的には、LookerでKARTEにあるデータを見て分析し、その結果をもとに再度KARTEに戻って施策を実行するというアプローチが可能になるのです。」

KARTEとGoogle Cloudの連携

今井氏:「KARTEとGoogle Cloudの連携について説明しています。

このスライドはウェブサイトのスクリーンショットなのですが、KARTEとGoogle Cloudは深く結びついています。それはまさにGoogle Cloud Integrationという名の通り、両者のソリューションが一体化して使用できるようなアーキテクチャを提案しているからです。

また右側には”Customer Experience Analytics by KARTE”と記載されています。これは、一般的なBIツールを導入すると画面作成が必要になることを意味しています。」

Google CloudとKARTEの連携

今井氏:「Google CloudとKARTEとの連携について説明します。

KARTE Datahubのデータを後続のアクションに活用することが可能です。特にLookerのダッシュボードを用いることで、即時にデータを解析し、その他のツールとのシームレスな連携が可能となります。

例えば、BigQueryやSlackなど各種ツールへ、Lookerからのデータ連携が可能となります。 さらに加えて、LookerでKARTEのデータを見るためのテンプレートをあらかじめご用意していますから、すぐに導入して利用できます。

分析からアクションまで一貫して行える機能を備えたLookerを活用することで、データ活用の効率を大幅に向上させることができます。」

データ活用を推進する流れと実現のためのソリューション群

今井氏:「データ分析やデータ活用がビジネス運営に欠かせない要素となっています。

具体的には、ビジネスインテリジェンスを用いて施策の実行や業務ワークフローの改善を行い、これらのプロセスに機械学習を組み込むことで製品やサービスの開発が可能となります。

しかし、まずはデータを収集し、それを活用可能な形にまとめることが必要です。これが一番大変な作業となる場合が多いです。弊社では、データ蓄積と活用のプロセスを調整し、効率的なデータ分析と施策展開を実現しています。」

SECTION2:クイックにデータ分析基盤を構築するTROCCO®とDESとは?

Google CloudやKARTEを活用したデータ分析基盤の構築を支援

加藤:「primeNumberでは、Google CloudやKARTEといったサービスを活用して、データ分析基盤の構築を一手に引き受けます。このプロセスには、データの整備、前処理の構築、さまざまなビジネスロジックの実装、データウェアハウスの構築、データの可視化や活用などが含まれ、ビジネスの見える化を実現します。

また、コンサルテーションやデータバリデーション、転送や管理などの業務も行います。さらに、データの後処理構築や機械学習の利用、パイプラインの構築なども提供します。

つまり、データ分析基盤構築の全ての段階をワンストップで支援することが可能です。」

データ分析・活用へのプロセス

加藤:「データ分析と活用のプロセスは、データの分散から収集、蓄積、分析、そして活用までの一連の流れを含みます。この流れは、データエンジニアリングの進化と共にビジネス指標の改善や業務改革案の立案、オペレーションの改善など、ビジネス全体への貢献を目指します。

この中で、特に重要なのがデータ基盤の事前準備の工程です。これにはデータ収集と、それをストレージとして集約し、分析可能な形に変える作業が含まれます。

しかし、これらは手間がかかり、高いスキルが必要な作業でもあります。私たちの提供するTROCCO®は、こうした作業を自動化し、エンジニアの工数を削減するフルマネージドETL/ELTサービスです。

データの分散した状態から収集し、Google CloudのBigQueryに集約します。そしてLookerを用いてデータを可視化し、ビジネス施策に活用するという流れを簡略化します。

つまり、広範で分散したデータを集約し分析可能な形にするためのデータ基盤の事前準備という課題を、私たちのサービスが解消し、クラウド上でのデータ活用を推進していくことが可能となります。」

データの統合の工程 TROCCO®が自動化する部分

加藤:「データの統合は、多くの工程から成り立ちます。これら約18の工程は時間と手間がかかりますが、私たちTROCCO®が提供する機能やサポートにより、これらの工程の大部分を自動化することが可能です。

たとえば、データツールの選定、各データカラム内容の仕様確認、認証情報の取得、データリソース仕様調査などの要件確認までを扱います。

また、エラーや結果の出力、ETLシステム構築、サーバーやノワォーマンスの要件確認などのセキュリティ面も考慮したワークフローを提供します。

さらに、出力データの確認、分析データマートの生成、BIなどのデータ更新、統合後のデータ活用をサポートします。

これらは、TROCCO®が自動化できる工程です。」

TROCCO®とは

加藤:「TROCCO®は、企業のマーケティング、広告、フィールドデータ、アプリケーションデータなど、散在している様々なデータを自動的に集めて、データウェアハウスや蓄積データへと自動転送できるシステムです。

単純な転送だけでなく、データの表記ゆれの修正や、簡易なデータ加工を実施してから転送を行うことも可能です。また、転送後のデータ同士の突合せも可能にしています。

これらの作業を全て自動化することで、事前の準備作業を最大90%削減できます。その操作はGUIを用いて直感的に設定することができ、エンジニアリングスキルが必要ないので非エンジニアの方でも活用できます。

さらに、接続可能なデータソースが130種類以上あり、国内で最も多くのデータ接続が可能なシステムです。」

データ活用の簡易アーキテクチャとTROCCO®

加藤:「TROCCO®の特徴について説明します。

1. どのように各データソースからKARTE・BigQueryへデータを転送するか

2. データマート機能とワークフロー機能で一連の流れを完全自動化する方法

3. 豊富な接続サービスの紹介

これらはすべてTROCCO®で管理可能で、顧客データや広告、MAデータなどを一元管理し、それを分析ツールやCRMに連携できます。

例えば、BigQueryやKARTEと組み合わせることで、顧客のセグメンテーションやスコアリング、要約分析などを行うことができ、これに関連するワークフローを完全に自動化できます。

また最初のステップとして、顧客が保有するデータを簡単に5~10分で自動的にKARTEやBigQueryに送ることが可能です。

データ送信後に、それらの流れを全て自動化するためのワークフロー機能を提供しています。これにより、一連のデータフローをすべてTROCCO®で管理できます。

さらに私たちの提供する接続サービスの数も特徴的で、多くのデータソースや分析ツールとの連携が可能です。これらの機能を活用すれば、約1ヶ月程度でデータ基盤を構築できます。」

豊富なコネクタ

加藤:「私たちは、100種類以上のコネクタを提供しており、各種データソースとの連携が可能です。最短で5分程度でデータバイプラインを作成できます。

これにより、例えば広告関連のデータやアプリケーション、KARTEなどのデータ、更にはお客様が保有している各種サービスとの連携も可能です。

当社が提供する100種類以上の豊富な接続コネクタを使うことで、わずか5分でデータのパイプラインを作成できます。これによりデータウェアハウスやファイル・ストレージ関連のデータパイプラインの構築工数を大幅に削減できます。さらに、Google Cloudの各種サービスやGoogle Spreadsheetなどとも連携できます。

TROCCO®のデータ活用ツールは、さまざまな業種や規模の企業に導入されています。国内外から300以上の企業が利用しており、中小企業から大手企業まで、全業種が含まれています。」

各ツールは繋ぎ、活用することが重要

加藤:「ツールの導入は終点ではなく、それを有効に活用するプロセスが必要です。ツールを適切に結びつけて全体的に活用できる状況をどう構築するか、それが大切です。

その構築と活用を誰が実施するかという問いに対しましては、当初から支援を提供すべきだと考えています。」

DESでは、構築・活用を支援

加藤:「TROCCO®はデータ分析の総合支援SaaSおよびETL/ELTサービスを提供しています。これはデータエンジニアリングソリューションと称し、データの構築と活用を支援します。

具体的には、データの統合や運用、分析を推進するために必要な手順をサポートしています。」

pN-Integrationサービス内容

加藤:「pN-Integrationサービスは、データ分析基盤を一貫して構築する支援を行います。pN-Integrationはデータの点在からビジネス提案までの全プロセスを包括しています。

まずはお客様が保有するデータの種類や位置を把握し、必要なデータを選定します。その後、このデータを抽出、変換、加工し、ストレージに集約します。これらのデータを基に分析を行い、ビジネスの視覚化を実現します。

分析結果は売上向上、コストやロスの削減、オペレーション改善などの具体的なビジネスアクションへと結びつけます。

お客様がデータを活用して目指すゴールが何であるのかを伺い、そのゴール達成のために必要なデータ収集から基盤構築までをワンストップで実施するのが私たちのサービスです。」

事例:企業全体のKPI管理ダッシュボードの構築

加藤:「この事例では、企業全体で使用するKPI管理ダッシュボードの構築を行っています。

複数のサービスがあり、それらをTROCCO®で取り扱い、BigQueryでデータを集約しました。その後、BIツールに接続し、全社で活用できる形にしました。

これにより、売上向上やコスト削減など、企業全体の状況把握に役立ちました。具体的には、管理部門やマーケティング部門などで様々なKPIを用いていますが、これらを一覧で管理できるダッシュボードを構築しました。

また、ダッシュボードで表示する「実績」、「予算」、「予測」の粒度を設定し、それに合わせたデータの管理やメンテナンス方法も設計しました。」

データの選定とその種類・場所の把握が重要

加藤:「データ活用を実現するためには、データが点在している現状を解消し、データの抽出、変換、加工、ストレージ、集約し、それを可視化し分析するという一連の流れが必要です。

その中で特に重要なのが、必要なデータの選定とその種類・場所の把握です。これによりコストやオペレーションのロスカットを実現します。

TROCCO® を活用すれば、このプロセスをより効率的に実施できます。私たちのホームページではその他の具体的な事例も掲載しておりますので、ぜひご覧いただければ幸いです。」

SECTION3:データの具体的な活用方法やデータ活用推進

つづいて、データの具体的な活用方法やデータ活用推進について、石塚氏からご紹介いただきました。

二刀流のデータ基盤

石塚氏:「二刀流のデータ基盤というテーマで話をしていきます。これは、顧客分析とアクションを結びつけ、全社でのデータ活用推進を実現するための戦略です。私の所属する株式会社プレイドのGrowth Acceleratorチームでは、このようなアプローチを採用しています。」

本日のアジェンダ

石塚氏:「今日お話しする内容は、データ分析から実際のアクションに移すまでの一連のフローについて、プレイドの事例を挙げて説明します。この実例を通じて、どのように顧客分析とアクションをつなげていくべきか、示唆を得ていただければと考えています。

まず自社の説明と分析の前提について短く説明し、一般的によくある問題点について触れます。その上で、これらの問題に対してプレイドがどのようなアプローチを取ったのかを事例とともにお伝えします。最後に全体のまとめをお話しする予定です。」

本講演で伝えたいこと

石塚氏:「今日私が伝えたい主要なコンセプトは3つあります。

第一に、具体的な課題を明確に定義すること、第二にデータ役割の合意形成、そして第三に現場推進者との共同作業です。

これら可能性としては抽象的に感じるかもしれませんので、「何を課題とするのか(What)」、「どこまでがデータの範囲とするのか(Where)」、「誰と一緒にこの課題に取り組むのか(Who)」という3つの観点を念頭に置くことが重要だと言えます。

これら3つの要点を押さえることで、顧客分析を具体的な施策につなげることが可能になります。」

株式会社プレイドについて

石塚氏:「株式会社プレイドは、2011年に創立された、現在は約340名の従業員規模の会社です。そして弊社の主力プロダクトである「KARTE」は、2015年3月に正式にサービスを提供開始しました。

その後、2020年には東京証券取引所マザーズに上場を果たしました。さらに、様々な企業との合弁や子会社設立、過半数株式取得を通じて、グループ体制を築くと共に、ビジネス領域を広げてきました。

特に、エモーションテック社との経営統合により、NPSなどのサーベイ分野のサービス提供も本格化し、新会社「株式会社RightTouch」の設立により、カスタマーサポート分野へも正式に参入しました。最近では、アジト株式会社の過半数株式を取得し、インターネット広告領域のサービスも拡充しています。」

プレイドグループが目指す姿

石塚氏:「プレイドグループが目指しているビジョンは、様々なチャネルから得られるデータを集中管理し、それを一人の顧客データとして統合することです。そして、この統合されたデータを解析し可視化した上で、それを活用してユーザーに還元することを目指しています。

具体的には、オンラインや店頭、さらにはLINEなどから得られるデータを一元化し、これらを一人の顧客と結び付けることで、個々のユーザーが体験する広告やショッピングなどの場面において、最適な情報をリアルタイムに提供できるプラットフォームを提供します。

その結果、これまでにない新しいマルチチャネル、1stパーティ顧客データ、リアルタイムなデータ活用プラットフォームの提供を目指しています。」

グループ事業概要

石塚氏:「「KARTE領域」と「新規領域」、グループ全体のビジネス領域について説明します。今回の主な話題は「KARTE領域」で、企業のCX(カスタマーエクスペリエンス)やマーケティングの向上を支援する製品やサービスを提供するエリアです。「KARTE」と、その製品を活用する企業の取り組みについて深く掘り下げます。

「KARTE」は、訪問者のオンライン行動をデータとして捉え、その人の状態や属性に合わせたコミュニケーションを実現するツールです。

もう一つの製品は「DataHub」で、これはデータプラットフォームのサービスです。

それぞれがどのように機能しているかを理解することで、データ活用推進の取り組みがどのように進んでいるか理解を深めていただけると思います。」

社内データの活用基盤

石塚氏:「当社では、主にSFやKARTEで生成されるデータをDatahubというプロダクトに集約してデータウェアハウスを実現しています。その他にも例えば、セールスフォースからの商談や契約情報などのデータも統合しています。

これらのデータを基に、KARTEを活用してオンライン上での各種施策の実行や、Lookerを使ったデータ分析・可視化ができます。

データ活用基盤を持つことで、データ収集、統合、活用という一連のプロセスを適切に管理し、全社的なデータ活用推進を可能にしています。」

データを活用したGood Case

石塚氏:「データの活用による良好なケースを紹介します。

問題を発見し、データに基づいた解決策と、その結果を見直し次の行動に繋げるという流れができていると、データがうまく業務に活用されていると言えるでしょう。

例えば、営業の方から「商談の受注率が低い」という相談があり、それに対し分析側がデータをもとに「商談のフェーズが30から50への移行率に大きなギャップがある。そして、その原因は決裁者に会えていなさそうだ」という示唆を与えたとします。そこで、その示唆を基に「決裁者との関係構築のための施策」を実施します。

3ヶ月後にその施策の成果を検証したところ、「30から50へのフェーズ移行率が20%改善した」という結果が確認できた一方で、新たに「提案フェーズでの滞留が目立つ」という問題が浮上しました。

そこで再び、この新たな問題に対する次の実施に繋げることができます。

現在の課題に対してデータに基づいた示唆を得て、それを行動に移し、その結果を見直し、次の課題や行動に繋げていくサイクルが繰り返される企業は、データを効果的に活用していると言えます。」

こんなご経験ありませんか?

石塚氏:「データ分析で経験した問題点について解説します。

「分析結果を円滑な業務推進のためにダッシュボードにまとめて提示したけれど、興味を持ってもらえなかった」、「分析結果を提示したものの、それが実際の業務改善に繋がらなかった」という事例があると思います。

これらの問題は、勘や経験に頼った業務が進行していることを意味します。

では、なぜこのような問題が生じるのでしょうか?」

よくある課題感

石塚氏:「データ活用の際に大きな壁となる二つの問題が存在します。一つはデータの統合、もう一つは統合したデータの活用です。

データが分散している場合、まずその統合について考える必要があります。何とか乗り越えて統合ができたとしても、統合したデータをうまく使うのが難しいのが現状です。この問題を解決した上でデータを活用して改善を進めていくことが理想的です。

紹介した二つの事例は、この「活用の壁」にアプローチしています。このデータ活用の壁を中心に、事例を紹介していきます。」

多くの会社の実態

石塚氏:「データの統合や戦略的活用について調査した結果、具体的に取り組み成果を上げている企業は全体の5%に過ぎません。32%の企業が現在取り組み中で成功することを予期しています。

DX(デジタルトランスフォーメーション)推進の取り組みをみると、新たな価値提供、ビジネスプロセスの標準化や再設計、データの活用、デジタルツールによる業務改善、既存システムのモダナイゼーション、ツールの展開、ペーパーベースの情報のデジタル化などが挙げられますが、具体的に取り組んで成果が出ている企業は少ないです。

しかし、こういった取り組みを開始している企業は多く存在し、これからの成果が期待されます。

このような状況からわかることは、まだデータ活用に関する課題や壁は多いが、それを乗り越えるための様々な試みや取り組みが行われているということです。」

本日紹介する事例の概要

石塚氏:「Customer Success(CS)チームが「KARTE Datahubの使用状況を具体的なデータから理解したい」という要望に対する取り組みについて解説します。

ある日、Customer Successのチームのマネージャーから、「データハブというプロダクトをどれだけ活用しているのかデータで明らかにしたい。」という相談を受けました。

このKARTE Datahubは、弊社が提供するデータプラットフォームで、その利用状況を理解したいというのが今回の要望でした。」

まずはアプローチを整理

石塚氏:「まずは、私たちのアプローチについて整理します。大きく分けて「課題の再定義」、「分析」、「施策実行」の3つのステップで取り組んでいます。

「課題の再定義」では、何を改善したいのかを明らかにしています。次に「分析」では、再定義した課題に基づきデータを分析し、改善への指針を明確化しています。最後の「施策実行」では、分析結果に基づき施策を実施しています。

このように、課題の明確化から施策の実動へと繋げる一連の流れを整理し、それに沿って取り組んできました。」

重要な視点とは

石塚氏:「ここで重要な視点は、何をゴールとするかです。最終的には、課題解決を達成するためにはどのように行動を変えるべきかということです。

これを実現しようとするときに必要な要素として、現場の推進者たちと共同でプロジェクトを推進し、試行することが不可欠になります。

重要な視点は、「データと現場との役割分担の明確化」が推進の滑らかさに繋がる点です。

最終的には、課題解決に向けて行動を変えることがゴールです。そのためには、全体として現場推進者との協働が必要です。その上で、データと現場のどちらがどの範囲までを担当するのか、役割の明確化が重要となります。

データ解析までをデータ担当、その結果を元にした実行部分を現場が推進する、といった役割分担こそが、効果的なデータ活用となるでしょう。」

課題の明確化

石塚氏:「重要な視点は役割分担の定義ですが、それを明確にするためには「課題の明確化」が必要です。私たちのゴールは、この課題解決を実現するために、それに応じて適切な行動を起こすことにあります。そして全体を通じて、現場の推進者と協力しながら作業を進めることが重要です。

データの役割を示すためにも、まずは課題を明確にし、その課題にどういったデータが役立つのか共有し合うべきです。そういった合意形成を通じて、全体の流れを理解し、共に行動を推進し、最終的には行動の変化を促すことです。これが私達の進めていくべきプロセスにです。」

アプローチ詳細:課題の再定義 1/2

石塚氏:「私たちの課題は、顧客のサポートが不十分な結果、想定外の顧客離れ(churn)が生じることです。

顧客サポート担当者が複数の案件を抱えている場合、全ての案件に対しての使用状況や状態が確認できません。その結果として、どの案件を優先的にサポートすべきかを主観的な感覚や経験に基づいて決定せざるを得ない状況に陥っています。

このため、一部の案件についてはサポートが不十分となり、結果的に顧客離れを引き起こしてしまいます。

そこで、私たちは顧客の状況を客観的に把握し、適切なリソースを割けるようにすることでこの問題を解決するべきだと考えています。

問題は、クライアントを十分にサポートする人員を割けていないこと、それが結果として予期せぬクライアントの離脱(churn)を引き起こしているという点です。

これを解決するためには、「クライアントの状況を客観的に把握し、適切な人員を割くことのできる状態を作る」ことが必要です。

しかし、具体的な問題案件を見れば、「誤った方向への分析が進行してしまう」、「進行したとしても課題当事者から理解が得られない」といった事態が発生し、結果として事業推進が停滞してしまいます。

これが、私たちが抱える課題です。

私たちの課題は、活用すべきデータが不明確であり、担当者が独自の感覚で優先順位を付けたり、支援してしまうことから、予期せぬクライアントの離脱が発生してしまうことです。

課題の適切な理解ができないために、誤った方向に分析が進み、課題当事者が理解できず、推進が停滞してしまい、行動の変化を引き起こすことができません。

課題を正確に理解し、整理することが非常に重要です。」

アプローチ詳細:課題の再定義 2/2

石塚氏:「課題解決の具体的なアプローチの一部として、”客観的な状態把握”と”状態が好ましくないクライアントへの適切なアプローチ”が必要であり、それぞれをデータ分析とCSチームの活動領域として整理しました。

それぞれの案件について、活用状況と優先度をデータにより明確にし、結果に基づいてどの案件を優先的にサポートするかを決定します。

具体的には、活用状況が良好なA案件、改善が必要なB案件、問題が発生しているC案件のように、それぞれの案件の状態を視覚的に信号の色で表現します。

そして、客観的な状態評価に基づいて優先度をローやミッド、ハイに分け、それに応じた支援を提供します。

これにより、継続利用率の向上を目指しています。理想的な状態は、活用状態に基づく優先順位付けを行い、それに基づいて適切な支援を提供し、継続利用率の向上を達成することです。

課題解決のためには、まず客観的な状態把握と状態の悪いクライアントへの適切なアプローチが必要です。

客観的な状態把握はデータを用いて行い、適切なアプローチはCSチームが行うと想定しています。しかし、これが不適切だと課題の解決に向けた期待値と現実が離れてしまい、課題の当事者が必要な作業を行うための時間を確保できなくなり、結果としてデータ活用が進まなくなります。

これを防ぐためには、どの作業がデータを用いて可能で、どの作業がデータを用いては不可能なのかを理解することです。そのうえで、データを用いて明らかにできる部分はデータで明らかにし、データを用いて解決できない部分はCSチームが進めます。

しかし、現実にはこの住み分けが難しく、データが明らかにすべき領域をCSチームが行おうとすると、期待と現実のギャップが生まれてしまい、結局データ活用が進まなくなるケースがあります。

さらに、CSチームが進めるべき事項まで進めてしまうと、追加のリソースが必要となる場合がありますが、そのリソース確保が難しくなり、後々問題が発生する場合があります。

このような問題を避けるためには、データ活用を進める際、データで明らかにするべき部分と、それ以外の部分について、きちんと役割分担することが重要です。」

アプローチ詳細:分析

石塚氏:「今回の取り組みは、データの確認から始まり、それに基づいて分析方針を検討し、その方針に従って集計や可視化を行い、さらにフィードバックを得るという一連の流れを二回実施しました。これにより、納得感のある分析結果を得ることができました。

第一サイクルでは、初めに「Datahub」の利用状況などを確認し、アクティブな状態を一つの指標として評価しました。その結果、一定の評価を得ることができ、また新しい取り組みへの着手も必要であるとのフィードバックを得ました。

次のサイクルでは、新たに集めたデータを用いて、実際に新しい取り組みを開始し、それをクエリの実行回数から評価しました。

結果、両方の指標が一定水準を超えている場合を理想的な状態と定義し、その基準に基づいてカスタマーサクセスマネージャーとのフィードバックを得て、実際の取り組みを進めることができるとの意見を得られました。

データ分析のアプローチは、まずデータの確認から始まり、次に分析の方針を検討し、集計や可視化を行います。その結果に対するフィードバックを受け取る流れとなっています。この一連の工程を2回繰り返すことで、分析結果への納得感を向上させています。

しかし、重要な点は、分析結果が出てきた後でどう対応するかです。ここで得られたフィードバックに基づいて改善を進めることが重要です。

そのため、現場の推進者と密接に連携し、納得感を持ちつつプロジェクトを進めることが非常に重要です。」

アプローチ詳細:施策実行

石塚氏:「指標に基づいて、パフォーマンスが低下しているクライアントに対して、カスタマーサービス担当者が関与する方法を進めています。この方法の効果を検証しつつ、結果によって行動計画を調整する予定です。

カスタマーサービスの内部で、クライアントの状況に応じた効果的な施策を検討し実行するための試行錯誤が進行中です。

具体的には、二つの軸「新しい取り組みへの意欲」と「活動状況」でクライアントを分類し、その状態に基づき適切な施策を選択します。

例えば、活動状況は低いが新たな取り組みに積極的なクライアントには施策Aを、新規取り組みへの意欲は低いが活動状況が高いクライアントには施策Bを、どちらも低いクライアントには施策Cを提案します。

このような施策の選択と実施をカスタマーサービス内で試行錯誤しながら進めています。なお、適切な施策の実行には、現場推進者との協力が非常に重要です。」

取組の全体像

石塚氏:「私たちの取り組みは、「課題の再定義」、「分析」、「施策実行」という流れで推進されるものです。

それぞれのフェーズにおいて課題が存在します。まず課題の再定義の部分で、データの活用状況が不明瞭であれば、どこまでをデータの活用実態で分析、判断するのかを明確化します。」

取り組みを通して依頼組織からの評価

石塚氏:「私たちの取り組みに対して依頼組織からは、「分析結果に納得感があり、改善活動はCustomer Successにて担当」という評価を受け、さらには「データの観点から今後も支援をお願いしたい」という追加の依頼もありました。

具体的な指標化により、「いいね!」という肯定的な反応と、「改善トライします!」という積極的な取り組みが見られるようになりました。

それだけでなく、「この先も様々な試みをデータを元に推進して欲しい」という新たな依頼もあり、私たちの取り組みが正しい方向に進んでいるという証拠だと思っています。」

今日伝えたいこと

石塚氏:「主に顧客分析を効果的に活用し、それを具体的なアクションに繋げるポイントは三つあります。課題の明確化、データトラックの割り当てに対する全員の合意形成、そして現場での推進者と共に進めていくことです。

これらのポイントがデータ活用の効果を最大化するための重要な要素であり、理解と認識が必要です。」

円滑に進めるためのTIPS

石塚氏:「円滑なデータ活用を進めるためのテクニックをいくつか紹介します。

一つ目は、実際の業務に自分自身が参加することです。

自分が実際に業務を経験することで、データの課題に対する理解度が深まり、会社全体がデータ活用を進めやすくなります。

私自身もカスタマーサクセスの業務に参加し、多くの案件を前線で経験しました。結果として、現場の状況をより正確に把握し、変革を推し進める人々からの信頼を得ることができました。これは、データを活用しやすい環境を作るための重要なステップです。

次に、データは万能な解決策ではないことを理解します。理想的なデータがない場合でも、課題が何であるかを明確にし、課題に基づいてデータの整理を進めることが大切です。

最後に、課題解決の当事者と協力しながら取り組みを進めることです。これにより、プロジェクトがよりスムーズに進みます。」

KARTE/KARTE Datahubを活用するメリット

石塚氏:「私たちのプロダクト、KARTE / KARTE DataHubの利用について、具体的なメリットをお伝えします。

一言で表現すれば、データ収集、統合、活用の一連のフローが充実します。それぞれのプロセスにおいて、KARTE / KARTE DataHubを使うことは、一定のメリットが得られるでしょう。

詳細について興味があれば、別の機会にご説明いたします。ありがとうございました」

まとめ

本セミナーでは、「二刀流のデータ基盤!顧客分析とアクションを繋げて全社でのデータ活用推進を実現」について解説していただきました。データ分析基盤は構築したあとが重要です。各社の現場でのフローや、最前線の取り組み方などが参考になったと思います。

「Looker」によってデータを可視化し、「KARTE」で顧客分析施策を実現し、そして「TROCCO®」でデータを集約することで、データ分析基盤の構築と効率化が実現できます。

各種データを活用した顧客分析の施策に課題を抱えている方は、本内容を参考に、データ分析の更なる効果的な活用を目指してみてください。

弊社の提供するデータ統合ツール「TROCCO®」は、データの統合や分析をサポートする多機能なツールです。興味のある方は、クレジットカード不要のフリープランでのお試しも可能ですので、この機会に是非ご利用ください。