総合転職サイト「エン転職」や国内最大級の総合求人サイト「エンゲージ」をはじめ、主にHR領域の事業を多数展開するエン・ジャパン株式会社。2018年に東京証券取引所市場第一部(現・東証プライム市場)に上場し、20以上のプロダクト、サービスを積極的に展開する同社が2024年7月に設立した部署がAIテクノロジー室です。

データ基盤も専門人材も不在の状況から紆余曲折を経て、プロダクト横断のデータ集約やAIアルゴリズムの開発までを担う組織に進化を遂げています。本セッションでは、今に至るまでの課題解決プロセスを「組織の成長」と「データ基盤の進化」の2つの観点から振り返り、AIドリブンな企業を実現するための要点についてご紹介いただきました。

登壇者紹介

松尾 祐太郎氏

エン・ジャパン株式会社 AIテクノロジー室 データサイエンス第1グループ マネージャー

2012年にエン・ジャパンに新卒入社。プロダクトマネージャーとして、複数サイトの企画開発・グロース施策・データ分析を歴任。2019年にデータ分析の専門部署を立ち上げ、エン・ジャパンのデータ戦略の立案と実行を担う。現在は、15名のデータアナリストをマネジメントしながら、顧客データベースを活用した大規模データ解析を推進。Tableau の認定資格「Tableau DATA Saber」の保有者。

濵田 宏一氏

エン・ジャパン株式会社 AIテクノロジー室 チームリーダー

2002年立命館大学理工学部を卒業。Sier でシステム開発、製造メーカーにて建設機械の電装品とソフトウェアの品質保証業務に従事。2016年からベンチャー企業の立ち上げに参加し、 AI を利用した介護支援サービスの開発、運用を経験。現在はエン・ジャパン株式会社にて、データ分析基盤の構築と運用保守を担当。

ゼロから始まった、AIアルゴリズムの開発を担う組織の立ち上げと成長

「組織」と「基盤」に絞ったAIドリブンカンパニー化に向けた取り組みをスタート

昨今のAI技術の発展を受け、経営層から「AIを活用したい」とリクエストされた松尾氏。当時、同社にはデータ基盤やデータの専門組織、AI人材は存在していませんでした。

まずはデータ活用の小さな成功を重ね、データ基盤の構築やデータ分析の立ち上げをすることに。その後AI活用のために既存社員へのリスキリングやビジネス人材と専門職人材の採用を試み、データの専門人材を増やしていきました。組織はAI組織へ拡張され、2024年7月にはAIテクノロジー室が発足されました。

同社で組織の成長を考える際に、目指すべき理想像として「AIドリブンカンパニー」を掲げました。「AIドリブンカンパニー」と聞くと、AIを中核に据えて事業活動を行う企業像をイメージしますが、同社ではそこからさらに深ぼって定義をしたと松尾氏は当時を振り返りました。

「日本経済団体連合会がまとめた指針のひとつに『AI活用戦略〜AI-Readyな社会の実現に向けて〜』というガイドラインがあります。このガイドラインでは、AI-Ready、つまりAIの活用ができている企業を5つのレベルに分けて示しています。

『AIドリブンカンパニー』とは、レベル4のAI-Ready化からAI-Powered化へ展開、つまりAIとデータによって企業価値を向上し、コア事業における価値を生むドライバーとしてAIを活用している状態だと私たちは定義しました。

さらにこのレベル分けを見ると『経営・マネジメント層』『組織(専門家、従業員)』『基盤(システムレベル・データ)』の3つの領域に分かれていますが、私たちの立場では『組織』と『基盤』に絞って進めていくことになりました。今回は私たちがデータ分析組織すらないゼロの状態からAIドリブンカンパニーに向けて進む道の入り口に立つ、つまりAI-Readyになるまでの成功や失敗についてお伝えできればと思います」(松尾氏)

組織の立ち上げはデータ分析の未経験者からのスモールスタート

AIドリブンカンパニー化に向けた取り組みは大きく3つのフェーズに分けて進められ、具体的にはフェーズ1で4年、フェーズ2で2年、フェーズ3が2024年からと、現在7年目に入っています。まず4年がかりのフェーズ1について引き続き松尾氏にお話しいただきました。

.jpg)

「まずはデータを分析、活用することをミッションとしたデータ分析組織を立ち上げることから始まりました。組織の立ち上げと聞くとおおごとのように感じるかもしれません。しかし実際には、当時の上司に本当にシンプルで小さな取り組みをアピールするところから始まりました。

例えば、ABテストの結果を一覧で参照できる効果検証の仕組みの作成や、KPIに関する数値のグラフ化を実施しました。プロダクトの課題に関する部分も統計など難しいことはせず、ファネル上のどこでユーザーが離脱したのか、クロス集計でどのユーザー群の歩留まりが悪いかなど、データを使ってコミュニケーションを行っていました。そうした積み重ねがきっかけで、より広い業務範囲で実現してほしいという上司からの要望を受ける形でデータ分析組織を立ち上げました。

-1.jpg)

最初は3人ほどの組織として立ち上げ、フェーズ1の4年間をかけて15人ほどの組織に拡大しています。組織を上手く拡大できたポイントのひとつが、最初からデータ分析のスペシャリストを社内から積極的に採用しなかったことです。営業やマーケティングといった実務経験があり、データ分析は未経験だが勘所はありそうな人材を採用しました。

当時はデータ分析をできる人がいたものの、先進的な取り組みができていたわけではありませんでした。そのためデータ組織の理想像を描くことができず、人材採用の要件を固めることが難しかったのです。

そこで組織全体がボトムアップしていくイメージで進めていきました。無理に先進的な取り組みに着手せず、現状で採用できる人材で実現可能なデータ活用にフォーカスしました。もちろんデータ分析の未経験者が多いため、自分たちでつくるのではなくprimeNumber社を含む外部の有識者からの研修を実施することでショートカットをする工夫をしました。

また、ビジネスサイドの社員がいきなりSQLコードを書けるようになるのは難しいでしょう。SQLが書けなくてもある程度データを扱えるようにするため、BIツールと最低限のデータウェアハウスを導入しています。これによってバラバラに散らばっていたデータをとりあえずまとめ、今後も蓄積していこうという意識を持たせることができました。

一方で失敗したこともあります。それがデータ部門化、つまりMA(マーケティングオートメーション)ツールの導入、運用支援やメールマガジンの企画、運営といったデータ分析以外の業務を引き受けてしまったことです。売上に貢献するため、人材要件が揃っていない中でも部門側の要望を受けていたのですが、結局はリソースが分散し、本来やりたかったことからどんどんズレていく実感がありました。

成功も失敗も経験しつつも、なんとかデータ分析組織を立ち上げたのが、フェーズ1の4年でした」(松尾氏)

組織が整い、いよいよAI活用がスタート。成功の秘訣はビジネス人材と専門職人材の二本柱

データ分析組織が整った状態で始まったフェーズ2の2年間で、いよいよAI活用がスタートしました。

「フェーズ2の時期には、AI活用に取り組むための人材がある程度は揃いはじめていました。何もない状態からのAI活用であれば、もっと苦労していたかもしれません。しかしフェーズ1でデータを扱うナレッジが蓄積されていたおかげで、データ分析のやり方を知っていたからこそAI活用が進めやすい状態になっていました。

また、AIテクノロジー室内に『AIを学んで活用したい』という積極的な社員が在籍していたこともあり、このタイミングでAI活用に取り組んだことは合理的な判断だったと思っています。

-2.jpg)

このフェーズ2の成功に繋がったポイントは、既存のビジネス人材とAIエンジニアやデータサイエンティストといった専門職人材の二本柱で取り組んだことでした。AIを活用するからといって専門職人材だけでは、必要なデータを収集できなかったり、ビジネス理解が不足していたりと、弊社のHR事業に役立つAI活用は実現できなかったでしょう。

その一方で、既存の社員に対してAIのリスキリングを行ったことは、大きなポイントだったと考えています。AI技術を学習すると自ら立候補してくれた15名ほどの社員に対して課題図書や学習プログラムを受講してもらい、現在では3名ほどの社員が弊社におけるAI活用のコアとなる人材に育っています。

逆に失敗したポイントは、ベンダー企業が過去に構築したAIロジックの改善です。AI技術をリスキリングしたばかりの社員が取り組みましたが、やはりドメインの知識がまだまだ足りず、私たちだけでは改善できませんでした。今振り返れば、この部分は専門職人材と一緒に進めていくべきだったと思います。

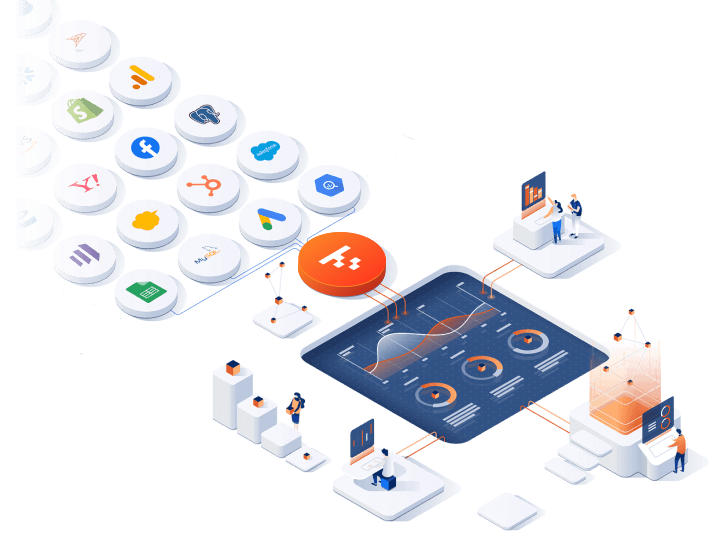

組織の成長だけでなく、データ基盤にも当時変化がありました。データエンジニアなどの採用を強化する前に、自由にデータを取得できる状態を実現したいと思っていました。そこで導入したのが、『TROCCO』でした。スプレッドシート上にあったり、広告代理店側の手元にあったりと、ばらばらに点在していたデータをAmazon Redshiftに集約していきました。

当時はどのクラウド環境を使うのが良いかも判断できなかったことから、とりあえずデータを取得することに注力しました。データが取れないよりかはいいのではと意思決定を行い、AWSとGoogleクラウドのどちらも使う方向で進めていきました。この取り組みはAIのモデル開発を行っていく、後のフェーズ3に繋がっていくことになります」(松尾氏)

競争優位となるテクノロジーコアの創出を掲げ、破壊的なイノベーションを生み出す独自AIの開発へ

AIテクノロジー室は現在、フェーズ3として「競争優位となるテクノロジーコアの創出」というミッションを新たに設定しています。このミッションによって、組織に求められる形態が変わってきていると松尾氏は話します。

「最も異なるのは、チームの目的ですね。これまでは、既存のプロダクトをAIで改善していく、いわば持続的なイノベーションを求められていました。しかし今私たちに求められているのは、競争優位となるテクノロジーコアの創出という、破壊的なイノベーションを生み出すことも求められているのです。

結果、自ずと重要になる人材が変わってきます。これまではゼネラリスト中心だった組織からスペシャリストの比率を高めていかねばなりませんし、評価軸も能力や成果が中心だったところを、研究開発のプロセスを正しく評価することが必要です。また、これまでは中央集権的に行なってきた組織の意思決定も、各チーム・各社員が自律分散的に改善・開発できる組織を構築しなければなりません。

さらに大きく変わったのが基盤です。これまでデータ分析を目的に構築していましたが、ここからは「AI開発ができる基盤」が求められます。

現在はAI-Readyな企業レベルでは3段階目、つまり既存の業務フローのAI✕データ化による自動化に目処がつき、戦略的なAI活用に着手しはじめた段階です。AI開発や基盤開発の人材がまだまだ不足しているので、しっかり採用戦略を組み、独立採算で予算をしっかり積んでR&Dを推進していきたいと思います」(松尾氏)

一人データエンジニアが取り組んだデータ基盤の進化と狙い

必要なデータをすぐに活用でき、データを使ったAI開発が可能な環境を目指して

データエンジニアとしてデータ分析基盤の構築と運用・保守を担う濵田氏からは「データ基盤の進化」というテーマでAIテクノロジー室の課題解決プロセスやこれまでの経緯をご紹介いただきました。濵田氏は昨年2023年4月の入社以降、同社内の調査や現状把握、導入すべき仕組みの検討を進めた結果、データ分析基盤であるDatabricksを中核に導入し、「エンゲージ」のデータを活用してTableau上でのデータ分析や、AI・機械学習モデルの開発ができる環境を整えてきました。

データベース内にこれまで蓄積されてきたデータをDatabricksに取り込み、データサイエンス業務に使用する環境の運用・保守に着手しています。さらに同時並行で、すでに導入されていたTROCCOやその他自社サービスとのデータ連携を現在も進めています。

-3.jpg)

「私がデータ分析基盤を構築する際にまず考えたのは、必要なデータをすぐに活用でき、そのデータを使ったAI開発が可能な環境を実現することでした。その上で検討したのが、こちらの5点でした。

- 理想のAI開発環境を整えるために必要な機能

- メンバーの使いやすさ

- 運用・保守の簡易さ

- データの管理場所や権限設定

- セキュリティレベルの担保

-4.jpg)

必要な機能として、まずはデータソースに接続してデータを抽出し、保存できること、データ分析ができてAI・機械学習モデルの構築、評価、検証、性能評価ができることが挙げられました。

また、実際にメンバーに使ってもらうためには、メンバーのスキルにマッチした仕組みであるかどうか、できれば直感的に操作できる仕組みが求められます。そして工数を低減できるという分かりやすく説明しやすいメリットもあれば、導入時のハレーションを最小限に抑えることが可能です。

運用・保守については、入社当時はデータエンジニアが私ひとりだったため、少人数でも運用・保守ができるシンプルさが求められます。

データ管理に関しては、データの保存場所と処理を行う場所が、エン・ジャパンが管理している国内サーバーであること、そしてユーザーごとに適切な権限を付与でき、さらにデータに対する権限設定が容易であるべきとも考えていました。

セキュリティ面においては、基本的にはデータ本体へのアクセスは絶対にできない仕組みとインフラを必須としました。さらに監査ログとしてユーザーの操作やクエリのログを収集できるものや、IPアドレスによる接続を制限する機能、多要素認証ができるものを探していました。

こうしたメンバーへの利用・展開・推進、機能、運用・保守、データ管理、セキュリティそれぞれの課題をまとめ、なるべく多くの課題を解決できる仕組みを導入しようと考えたのです」(濵田氏)

実際にデータ分析基盤を活用するユーザー像をイメージ。比較検討の結果、Databricksの導入を決定

実際のデータ分析基盤の構築ではまず、ユーザー像を捉えるために実際にデータ分析基盤を活用することになるデータアナリストやデータサイエンティスト、機械学習エンジニア、AIエンジニアの方々がどのようなスキルを持ち、どのような支援を求めているかを考慮したそうです。濵田氏がデータ分析基盤を開発した当時を振り返りました。

-5.jpg)

「データアナリストやデータサイエンティストのメンバーに関しては、SQLで必要なデータを抽出できる方々でした。さらに一部の方々は、Pythonによる処理も作成できると判明しました。それに対して、実際にインフラの構築やマシンスペックの選定、専門的なセキュリティ知識に関しては私が対応し、皆さんに使っていただける仕組みが必要だと考えました。

また機械学習エンジニアやAIエンジニアのメンバーに関しては、SQLやPythonでの処理はもちろんプログラミングもでき、AIの学習に必要なマシン性能も判断できます。そのため私からの支援は、インフラの構築や専門的なセキュリティの知識で充分だったのです。

次に着手したのは、データ分析基盤をどのような環境に構築するかでした。各種製品で比較した結果、今回選んだのがDatabricksによるデータ分析基盤の構築でした。もともとDatabricksがデータレイクから派生されたものであり、データ連携に一日の長があると考えました。さらにAIや機械学習の開発に関する機能においてDatabricksのほうが少しだけ充実していたため、Databricksを採用しています」(濵田氏)

検討ののち、2023年8月にはPoCが実施されました。ワークスペースの構築やノートブックによるデータマートの作成、SQLエディターによるクエリの発行や、AutoMLによるモデルの構築などが検証されました。また、Tableau Desktopで分析されるため、正常に接続ができるか、データの可視化ができるのか、Google BigQueryとの接続でGoogleアナリティクスのデータを取り込めるかを確認しています。そして2023年9月には、Databricksの導入を正式に決定しました。

Databricksを活用したデータ分析基盤の構築。当初の狙いを実現し、現在70名以上が活用中

Databricksを導入して構築したデータ分析基盤によって、どのような成果が得られたのでしょうか。比較検討やPoCの段階で描いていた狙いとその結果について、引き続きご紹介いただきました。

「データ分析基盤を構築する以前の課題は解決できています。Lakehouse フェデレーションでデータソースの接続がある程度容易にでき、Jupyter NotebookやSQLエディタでETL処理も実現できています。またクラスター構築も容易で、すぐに提供ができる点もよかったです。AutoMLでは機械学習、AIの開発を支援する機能もあります。

セキュリティについては、ブラウザ上でのオペレーションについて1年分の監査ログ、クエリ履歴を保存できています。シングルサインオンでのログインやIPアドレスによる接続の制限も実現できています。

データ管理や、運用・保守についても問題ありません。Amazon S3上のデータ保存や、クラスターも自社契約しているAWS環境に構築されていますので、私たちがやりたいことは満たされています。また、ユーザーやグループレベルの権限設定やワークスペースごとにサービスやグループ等でのセグメントの設定も可能です。

実際にメンバーに使っていただく流れについてもご紹介します。データ分析に関しては、ETL処理の作成として、ノートブックでETLの処理を作成し、フローの作成としてワークフローでデータの加工フローとスケジュールを設定しています。そこでできたデータマートをTableau DesktopからDatabricksに接続することで参照し、Tableau Desktop上でのデータ分析、可視化ができるような形になっています。

AIモデルの開発の流れについても、ノートブックで学習データの作成処理をつくり、そちらを動作することで学習データを作成。それをもって、AutoMLやノートブックで学習と評価を実行しているという形になります。

2023年の4月から現在まで駆け抜けてきましたが、2024年11月現在の全ユーザー数は76名となっており、データサイエンスグループ、AIテクノロジー室のユーザー数は現在27名です。今後は、Databricksに一本化をしていきたいと考えています。

最後に今後の展望として、やりたいこと、面白そうなことはたくさんあるのですが、いかんせん手が足りません。今後は、より多くのデータを活用できるように、安定かつ効率的にデータ運用ができるように、私も含めてメンバーの技術力、スキルの向上、そして新しいメンバーの育成にも力をいれていきたいですね」(濵田氏)

AI活用を「何とかする」からスタートした独自のAIモデルの構築。独自の予算を獲得し、採用を強化

今回のセッションでは、同社がAI活用を「何とかする」までにどのような施策に取り組んでこられたのか、赤裸々にお話しいただきました。データの専門組織はなく、AI人材もいない状態からスタートし、まずはデータ分析に取り組む組織を立ち上げました。そして次第にAIを導入するという新しいミッションを掲げたことをきっかけに、独自のAIモデルを構築していくところまで進化していきました。

「AIで独自のモデルを作っていくところに至るまでには、データ基盤の整備も必要です。フェーズ3までのデータ基盤は、正直そこまで先進的なものではなかったと思っています。その中でできることとして、データをとりあえず1カ所にためておくこと。ここをフェーズ1、2で進めました。

フェーズ2では、そこにAI活用というようなところが載ってきたので、データ分析ができるだけでは駄目だというところで、データ領域で専門スキルを持った集団に変えていくというのが組織のチャレンジでした。

ここでは、AIに関してリスキリングやAIエンジニア、データエンジニアなどの専門人材の採用を平行で実施していたことは大きかったかなと思っています。

採用にはとても時間がかかります。特に専門人材の採用はすごく難易度が高いので、早めに動けるなら、動くに越したことはないと思っています。そこを待つだけではなくて、できる範囲でデータを集めてきて、そこの専門人材と接続できるようなビジネス人材で、AIに強い人材を社内で育てるところを同時にやっていくところが重要だと思っています。

-7.jpg)

基盤に関しては、フェーズ3でようやく元々分散していたデータをDatabricksで一元管理することができました。分析、AI活用のどちらにも対応できる形になったと思っています。今後もTROCCOを通じて各種データを集約してきて、Databricksをデータレイクに特化させて活用していくという形を想定しています。

私たちAIテクノロジー室では『競争優位となるテクノロジーコアの創出』をミッションに掲げています。これからもデータを活用し、より良いプロダクトを届けられるような組織として進んでいけたらと思っています」(松尾氏)

Databricksにデータを集約し、AI活用を検討されている企業の方は、ぜひお気軽に株式会社primeNumberまでお問い合わせください。

データ分析基盤の構築・運用は

TROCCO®️におまかせ。

ETL/ELTパイプライン構築やワークフローなどを、SaaS上で実現。データエンジニアの工数を削減して、分析やクリエイティブな業務に集中しましょう。